Reportagem: Edilana Damasceno

Edição: Elena Wesley

Arte: Messias

Mais de 40% das empresas planejam adotar tecnologias de inteligência artificial (IA) em seus processos de recrutamento até o final de 2024. É o que aponta uma pesquisa publicada pela Resume Builder em junho de 2023. Seguindo a tendência de setores como atendimento ao cliente – que já automatizam tarefas de contato com o público, o ramo de recursos humanos tem apostado na IA como solução para reduzir o tempo gasto com os recrutamentos, otimizar as triagens e aumentar a assertividade das contratações. No entanto, diante de denúncias e reclamações de candidatos e profissionais, especialistas têm alertado quanto aos riscos de uma abordagem menos humanizada, que pode excluir pessoas de forma arbitrária e reforçar vieses discriminatórios.

Ainda que o senso comum transmita a ideia de que as tecnologias são infalíveis, especialistas se preocupam com a reprodução de preconceitos por parte dos algoritmos. Em 2015, profissionais da Amazon – uma das maiores empresas multinacionais do mundo – descobriram que os robôs preferiam candidatos homens em detrimento de candidatas mulheres. Isso aconteceu porque o algoritmo analisou a base de dados de currículos enviados à empresa e concluiu que, já que os homens eram maioria entre as candidaturas, a companhia teria preferência por esse perfil. Assim, os robôs passaram a dar notas baixas às mulheres candidatas. A equipe da Amazon ainda tentou tornar o algoritmo neutro, mas, como não conseguiu, deixou de usá-lo, como revelou uma matéria da agência de notícias Reuters, publicada em 2018.

Com mais de 20 anos de carreira em gestão de pessoas, a especialista em tecnologia e informação Andreza Rocha explica que as inteligências artificiais podem operar com vieses discriminatórios porque são influenciadas pelos mesmos problemas da vida real.

“As bases de dados ensinam os algoritmos a preferirem determinados perfis, porque as tecnologias são treinadas majoritariamente por homens brancos que alcançam sucesso no mercado de trabalho, logo as IAs vão selecionar pessoas semelhantes a eles”.

Andreza é fundadora da AfrOya Tech Hub, uma organização dedicada a inserir e desenvolver pessoas negras no ramo da tecnologia e inovação. Segundo a ativista, pessoas negras estão entre as que podem ser mais prejudicadas pelo uso indiscriminado dessas tecnologias, já que, assim como outros grupos, são afetadas pelas desigualdades sociais.

“Se as pessoas já não são atendidas pelas políticas públicas, o uso da IA em qualquer produto ou serviço vai ter seus reflexos nessa população ou até mesmo ter impactos contra ela”, acrescenta Andreza, que integra o Grupo de Trabalho de Raça e Gênero da Secretaria de Inovação, Ciência e Tecnologia do Estado do Rio do Grande do Sul.

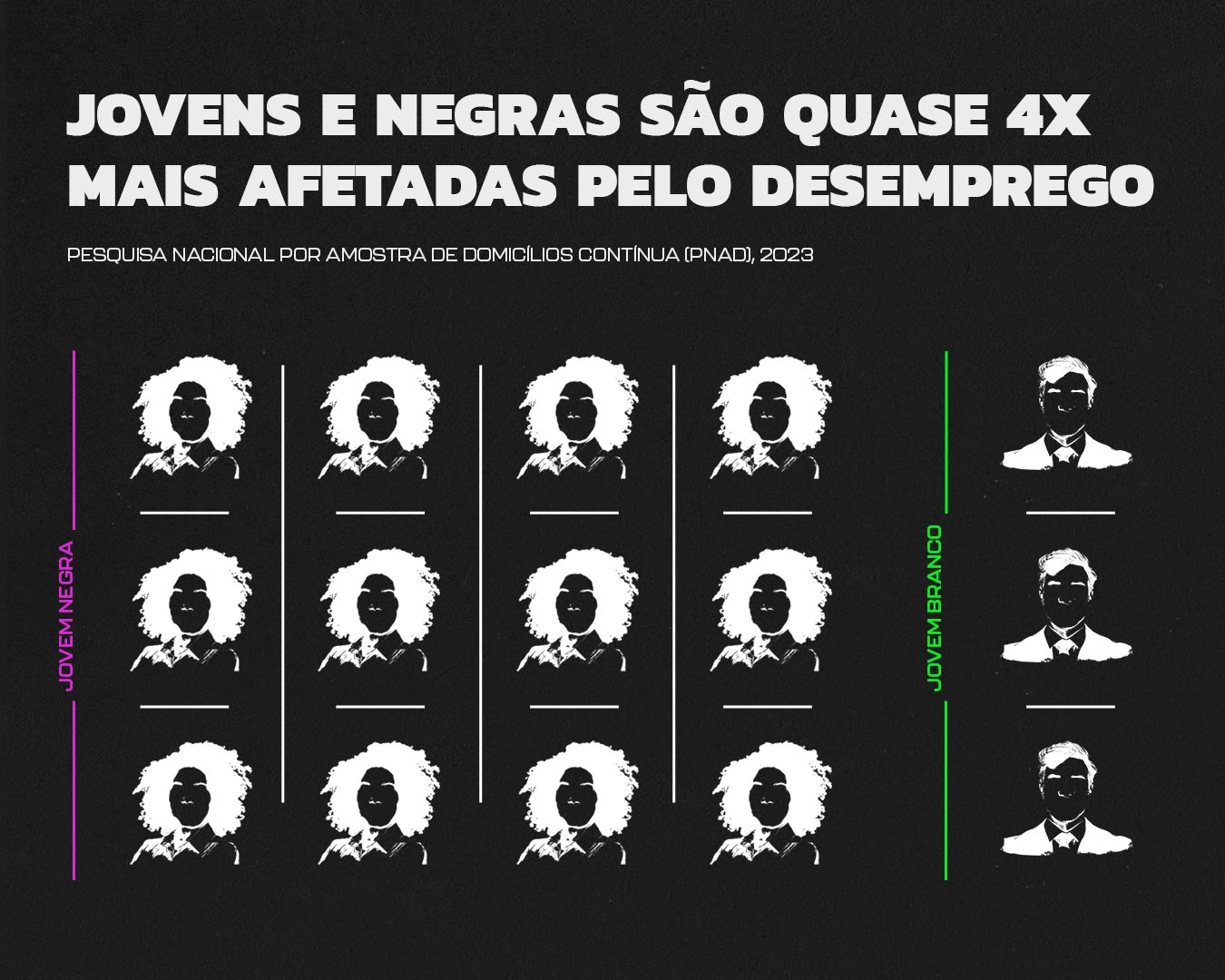

O relatório “Mude com Elas”, da ONG Ação Educativa, que se baseia em dados do IBGE, indica que o índice de desemprego entre jovens mulheres negras de 18 a 24 anos (18,3%) é quase quatro vezes maior do que o registrado para homens brancos da mesma faixa etária (5,1%). A publicitária Evelyn Reis, de 23 anos, conhece de perto a realidade apresentada por esses números. Faz seis meses que sua rotina tem sido participar de processos seletivos pela rede social Linkedin ou pela plataforma de recrutamento Gupy. Nestes canais, Evelyn raramente tem a oportunidade de interagir com um recrutador humano, já que as aplicações, em sua maioria, exigem o preenchimento de questionários, provas e testes de conhecimento virtuais

É desanimador sentir que seu potencial não está realmente sendo avaliado, ou que o tempo dedicado foi desperdiçado”, lamenta.

Usuários questionam falta de transparência nos processos realizados com inteligência artificial

Evelyn observa que os processos automatizados dificultam ainda mais o entendimento sobre questões abordadas pelas empresas nos processos seletivos. Ela relata que em um deles, realizado por um portal que utiliza IA em suas avaliações, seu posicionamento político foi questionado: “Perguntaram minha opinião sobre o atual governo e em quem eu votei nas eleições de 2022. Mesmo tendo sido sincera, fiquei desconfortável com a pergunta”, conta.

O especialista em desenvolvimento organizacional Saulo Carvalho explica que as empresas querem reduzir custos de operação, porém não enxergam a capacitação dos profissionais de Recursos Humanos como um investimento estratégico para chegar a este objetivo. Prova disso é a ocorrência de casos como o de Evelyn, quando perguntas ilegais são feitas. “São historicamente prejudicados por metodologias pouco eficazes e pela falta de preparo técnico. Raça, credo ou idade, por exemplo, não são critérios nem mesmo com base legal para selecionar funcionários”, argumenta.

Evelyn afirma que nunca foi informada sobre o uso dessas tecnologias nos processos, mas acredita ter lidado com elas em diversas ocasiões por ter visto notícias sobre o assunto e relatos de outros candidatos. “Chega uma hora em que a gente passa a identificar um padrão”.

Sites de queixas de consumidores como o Reclame Aqui já colecionam reclamações de candidatos sobre a falta de transparência nas seleções. Desde 2021, os concorrentes têm relatado não haver retorno sobre o que pode ter sido determinante para sua desclassificação. Analisando os casos, percebe-se que não está claro para os usuários a divisão de atribuições entre as plataformas de recrutamento e as empresas contratantes.

Num depoimento publicado em 2023, um usuário chamado Geovane questiona a discrepância entre as respostas dadas pelas duas partes. “Nas reclamações que abri só recebi a seguinte resposta: ‘Entendo sua insatisfação, mas a Gupy apenas disponibiliza a ferramenta para as empresas, e elas decidem como vão dirigir o processo, não temos envolvimento algum. De qualquer forma iremos direcionar sua solicitação para o Sesc, porém não consigo garantir um prazo de retorno’. Entrei em contato com o SESC para mais informações, e foi me repassado que eles dão continuidade de acordo com as informações que a INTELIGÊNCIA ARTIFICIAL da Gupy repassa dos candidatos”.

Num caso mais recente, registrado em setembro de 2024, uma usuária autoidentificada como Carla questiona o prazo de apenas dois minutos para responder a um teste de português e revela que já tem sido vendido na internet o serviço de adaptar o currículo aos padrões do que a IA da plataforma exige. “Infelizmente mais de 70% das vagas que me inscrevo são através dessa plataforma, que dificulta consideravelmente a evolução do candidato. Tem pessoas cobrando para alimentar o currículo de forma que passe pela análise da plataforma GUPY, e é lógico que as pessoas no desespero de conseguir um emprego acabam pagando. Foi-se o tempo que o os Humanos era para humanos, hoje em dia é o sistema, a inteligência artificial e o algoritmo que vencem e que se l@se (sic) as pessoas que precisam de emprego”.

Nem o Sesc nem a Gupy Tecnologia em Recrutamento responderam às tentativas de contato até o momento da publicação desta reportagem. No entanto, o site da Gupy disponibiliza informações sobre o papel da inteligência artificial nos processos seletivos. Em uma das notas, a empresa afirma que “a Inteligência Artificial não lê e nem leva em consideração qualquer resposta dada nas perguntas adicionais durante sua candidatura. A pessoa recrutadora é quem define isso. A IA só faz a análise e ordenação depois que o CV é enviado. A tecnologia da nossa IA é usada para organizar os currículos e mostrar quais pessoas candidatas inscritas em um processo seletivo têm mais afinidade com a vaga criada pela empresa”.

Em resposta às reclamações no Reclame Aqui, a Gupy tem informado aos usuários que a plataforma é uma ferramenta para que as empresas contratantes estruturem e administrem seus processos seletivos. “Os recrutadores das empresas contratantes utilizam os recursos da plataforma para construir um processo seletivo em etapas, avaliando competências importantes para as vagas a partir de recursos, como: testes, vídeo entrevistas, cases, etc. São os recrutadores de cada vaga que recebem o perfil das pessoas inscritas e podem avaliá-las, enviar comunicações e movimentar entre as etapas do processo”.

Sobre a metodologia da inteligência artificial utilizada, a Gupy acrescenta que a IA “calcula e ordena os currículos das pessoas candidatas inscritas em uma vaga se baseando nas experiências, conquistas e resultados de testes. Ou seja, ela analisa todos os currículos e lista para as empresas, começando dos perfis que possuem mais afinidade com a vaga para os que possuem menos. A Gupy IA só atua depois do envio dos currículos para a vaga, fazendo a leitura e ordenação desses CVs enviados. Mas independentemente da ordenação, todos os currículos ficam disponíveis para os RHs das empresas, afinal, a IA não toma nenhuma decisão e nem age por conta própria em ações complexas. A nossa Inteligência Artificial não analisa apenas palavras-chave, ela considera toda a trajetória descrita no currículo. Ou seja, mesmo que não esteja no CV as mesmas palavras da descrição da vaga, a IA entenderá o que foi escrito, porque ela analisará todo o contexto”.

Projeto de lei sobre IA exige transparência e segurança no recrutamento de candidatos

Um projeto específico sobre inteligência artificial foi aprovado no Senado Federal em dezembro de 2024, após a incidência de especialistas, ativistas e organizações da sociedade, que enfrentaram um intenso lobby das big techs junto aos legisladores e à opinião pública. Embora tenha sofrido alguns retrocessos às vésperas da votação principalmente pela atuação do senador Eduardo Gomes (PL-TO), relator do texto, o projeto de lei 2388/2023 manteve a classificação das plataformas de recrutamento como de alto risco. Isso significa que os aplicadores e desenvolvedores de IA dedicada a recrutamento, triagem, filtragem e avaliação de candidatos terão que seguir uma série de obrigações para diminuir riscos de violação de direitos e para informar a população sobre os sistemas.

“Antes de disponibilizar o produto ou serviço ao público, as empresas vão ter que assegurar com testes que o sistema é seguro, confiável, robusto, acurado e que não discrimina de forma ilegal ou ilícita. Também será necessário documentar todos esses testes para que possa prestar contas, tanto para o regulador, como também para as pessoas que vão usar esses sistemas e para a própria sociedade, explica a advogada Paula Guedes, que integra o grupo de trabalho sobre inteligência artificial na Coalizão Direitos na Rede (CDR). Formada mais de 50 organizações da sociedade civil dedicadas aos direitos digitais, a coalizão ministrou, em março de 2025, uma formação sobre IA na Câmara dos Deputados, onde a proposta será analisada e votada em breve.

Enquanto não há uma lei reguladora, a Lei Geral de Proteção de Dados (LGPD) é a principal legislação que aborda o tema. Vigente desde 2020, a LGPD obriga toda empresa que utiliza tecnologia para a área de Recursos Humanos a apresentar os critérios para decisões automatizadas de aprovação ou reprovação de candidatos. A legislação também assegura que o candidato à vaga solicite a revisão de decisões tomadas unicamente por inteligência artificial. Caso as informações não sejam fornecidas, a Autoridade Nacional de Proteção de Dados (ANPD), que é responsável pela fiscalização da LGPD, pode intervir a fim de verificar se houve discriminação no processo de tratamento dos dados do candidato.

Além do cumprimento da LGPD e do avanço do PL de IA, Andreza Rocha e Saulo Carvalho apontam medidas que possam colaborar para uma aplicação mais adequada das inteligências artificiais.

Saulo acredita que a IA pode ser uma ferramenta valiosa para a elaboração de programas de treinamento dos colaboradores, que ajudem a reduzir os pontos fracos já diagnosticados no setor de Recursos Humanos.

Estamos falando de gente, somente gente preparada poderá aplicar treinamentos. O olho no olho jamais pode ser desprezado nas etapas de recrutamento e seleção. Mas, na verdade, os humanos não olham nem mesmo os currículos. Se o currículo não está de acordo com o padrão da IA, ele será desprezado. E este currículo pode ser de uma pessoa com talentos extraordinários para a empresa. Como estamos vendo hoje e constato na prática, estes talentos não conseguem mais chegar a uma entrevista humana, um olho no olho”.

Andreza, por sua vez, apela para que a população não naturalize a narrativa de que as tecnologias são infalíveis e podem excluir pessoas. A especialista ainda destaca a importância de ações que busquem promover equidade, como é o caso do Projeto de Lei 4.553/23, que propõe alterações no Estatuto da Igualdade Racial para melhorar a coleta e análise de dados sobre a distribuição étnica e racial no mercado de trabalho. A partir de um critério da autoclassificação, a medida busca identificar o percentual de ocupação por parte de grupos sociais vulneráveis no setor público.

Tendo a acreditar que, com mais dados, seja possível identificar e gerar informações que fomentem as políticas públicas necessárias para aumentar a proteção aos trabalhadores mais vulnerabilizados”.