Reportagem: Isabella Rodrigues

Edição: Elena Wesley

Artes: Messias

O filme Minority Report – A nova lei (2002) descreve um mundo onde os assassinatos são previstos antes de acontecerem e seus culpados presos antes de cometê-los. Ambientado em 2054, o enredo traz o protagonista John Anderton como o chefe do departamento policial responsável pela prevenção dos crimes, que tem a vida transformada quando o sistema indica que ele mesmo iria cometer um assassinato. Embora seja uma obra de ficção científica, os fundamentos abordados pelo filme já estão presentes na realidade atual. Trata-se do policiamento preditivo.

Um dos casos mais emblemáticos desse sistema aconteceu em 2013, em Austin, no estado de Chicago, nos Estados Unidos, quando Robert McDaniel recebeu uma visita inesperada de dois policiais. Sem um histórico de violência e apenas registros de pequenas infrações por jogos de azar, Robert ficou surpreso ao ouvir que, segundo um algoritmo do departamento de polícia, ele tinha 99,9% de chances de estar envolvido em um tiroteio, como vítima ou agressor.

Com o nome no que seria chamada de “lista de assuntos estratégicos” (Strategic Subject List, traduzido do inglês), Robert passou a ser vigiado constantemente pela polícia, sendo abordado na bodega onde trabalhava e até acusado de posse de maconha em uma busca sem mandado. A vigilância sobre McDaniel levantou suspeitas entre os vizinhos, que culminaram em dois atentados a tiros. Ironicamente, o programa criado para prevenir crimes violentos trouxe a violência diretamente para perto de Robert.

O policiamento preditivo utiliza análise de dados para prever crimes e permitir à polícia antecipar ações, focando em áreas ou grupos de maior risco. Essa tecnologia se baseia em algoritmos que analisam padrões em acontecimentos passados e, a partir deles, tentam prever tendências futuras. Para isso, são considerados registros criminais, localização, dados socioeconômicos e até informações publicadas nas redes sociais.

Culpado até que se prove o contrário

Promovido como solução eficaz, o sistema levanta preocupações éticas por perpetuar vieses discriminatórios nos países que adotaram a ferramenta. É o caso da França, onde um algoritmo usado em 2015 durante a “guerra ao terror” estigmatizou a comunidade árabe, ao atribuir maior risco a pessoas com nomes de origem árabe, que frequentavam mesquitas ou tinham amigos árabes, rotulando-as como possíveis terroristas.

De acordo com Pablo Nunes, doutor em Ciência Política e coordenador do Centro de Estudos de Segurança e Cidadania (CESeC), existem três tipos de policiamento preditivo: o baseado em territórios, que prevê crimes em áreas específicas; em indivíduos, que analisa o risco de alguém cometer crimes; e em suspeitos, que cria perfis de possíveis criminosos, podendo violar a presunção de inocência.

É uma inversão do ônus da prova e uma forma de tentar prever crimes criando matemáticas para focar em indivíduos e regiões a serem policiadas”, explica.

O pesquisador alerta que identificar alguém como “suspeito em potencial” por meio de análises algorítmicas pode resultar em abordagens policiais injustas e discriminatórias em contextos onde a atuação policial já é marcada pela violência, como é o caso do Brasil.

O pesquisador acrescenta que essas ferramentas podem “criar uma sociedade que tem a vigilância como pilar da sua estruturação e na qual não há garantias de você ser inocente até que se prove o contrário”.

Promessas versus resultados

O Chicago SSL (Strategic Subject List), criado em 2013 para prever o envolvimento em tiroteios e que levantou suspeitas sobre Robert McDaniel, foi descontinuado em 2019. O sistema gerava “pontuações de risco” com base em históricos criminais e vínculos com gangues, sendo criticado por perpetuar desigualdades raciais, já que mais de 50% dos nomes incluídos na lista eram de pessoas negras de 20 a 29 anos contra apenas 2% de pessoas brancas. Em 2017, um noticiário local revelou que constavam na lista pessoas que nunca haviam sido acusadas de crimes violentos ou de porte ilegal de armas.

Sistema semelhante foi implementado em Los Angeles, na Califórnia (EUA) em 2015. A proposta do PredPol consistia em utilizar dados históricos para prever a ocorrência de crimes, na tentativa de direcionar as patrulhas policiais de forma mais eficiente. Embora tenha sido reconhecido como uma inovação pela revista TIME – uma das revistas mais influentes do mundo, o sistema gerou controvérsias significativas ao focar suas operações em áreas mais pobres. À época, especialistas alertaram que, ao invés de diminuir a criminalidade, o PredPol reforçava preconceitos, tornando a prática policial ainda mais injusta. A falta de comprovação de sua eficácia e as preocupações com discriminação levaram departamentos, como os de Oakland e outras cidades californianas, a descontinuar seu uso.

Em 2015, o Governo do Estado de São Paulo implementou o Detecta, o maior banco de dados policiais da América Latina, reunindo informações do Registro Digital de Ocorrência, Detran e outros órgãos. A inspiração para o programa veio do Domain Awareness System (DAS), um sistema de vigilância adotado pela polícia de Nova York em parceria com a Microsoft e considerado o maior sistema de vigilância digital do mundo.

Embora não tenha funções preditivas explícitas, o sistema usa câmeras para identificar ações suspeitas, como placas de veículos de pessoas procuradas. Após dois anos de sua implementação, a média de roubos aumentou e não houve evidências de impacto significativo no combate ao crime. Também não há dados precisos sobre quantas investigações realmente se beneficiaram das informações do Detecta, que custou aos cofres públicos cerca de R$30 milhões.

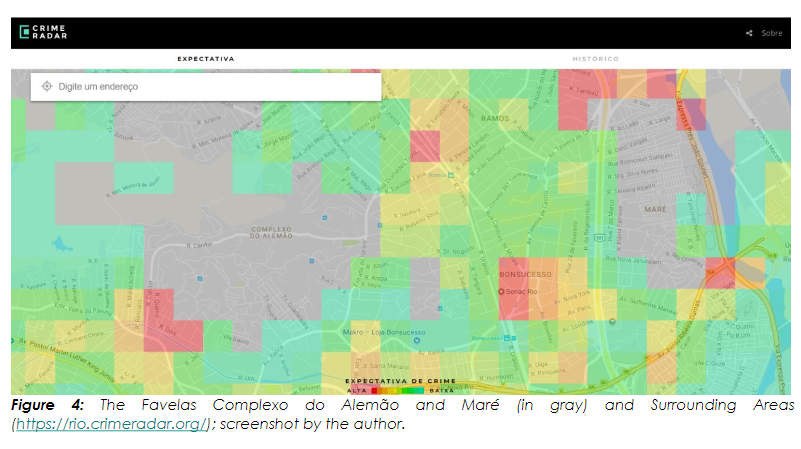

Nas Olimpíadas do Rio de Janeiro em 2016, o Instituto Igarapé lançou a plataforma rio.CrimeRadar de forma experimental, com o objetivo de prever taxas de crimes na região metropolitana a partir de algoritmos. A iniciativa foi criticada por considerar informações imprecisas dos registros policiais. Nesta versão inicial, favelas como a Maré e o Alemão não foram classificadas. Os desenvolvedores justificaram que os dados sobre esses territórios eram pouco confiáveis.

“Os algoritmos de predição utilizam dados históricos para fazer essas predições. Se os dados demonstram que uma área tem mais registros de determinado crime ou são mais focados pelas forças policiais em comparação a outra, a tendência é que o algoritmo sinalize esse lugar como uma mancha quente. Isso demonstra o quão problemática é a solução encontrada por essa organização [excluir áreas com dados pouco confiáveis]”, analisa Pablo. O pesquisador acrescenta que na União Europeia os sistemas de predição são classificados como um algoritmo de risco excessivo e que essa definição deveria nos fazer questionar qua a utilidade de uma tecnologia que aprofunda o foco em áreas que já são muito policiadas.

A CrimeRadar retornou em 2021, quando a entidade lançou um edital para implementar a plataforma em dois municípios brasileiros. A proposta prometia otimizar a alocação de recursos pelo poder público e ser uma estratégia de impacto social para mitigar vieses discriminatórios “não apenas no algoritmo, mas também na coleta de dados e nos procedimentos adotados pelas instituições de segurança”. Todavia, não havia detalhes sobre como os dados seriam coletados e armazenados, exigências da legislação brasileira, e em meio a críticas nas redes sociais, o edital foi suspenso. Em resposta à reportagem, a assessoria do Igarapé confirmou a descontinuidade do projeto.

A crença na neutralidade da IA

Apesar de ser defendida e comercializada como uma ferramenta imparcial, as inteligências artificiais (IA) não são neutras. As decisões sobre quais dados usar e como interpretá-los refletem escolhas feitas por programadores e instituições, que podem reforçar preconceitos já existentes na sociedade.

Um exemplo disso é a IA da Google, que catalogou pessoas negras como se fossem gorilas ou chimpanzés, conforme denúncia de um usuário do aplicativo Google Fotos em 2015. Ao invés de corrigir a classificação do algoritmo, a empresa preferiu remover a categoria “gorilas”.

Pablo alerta que o uso de algoritmos no policiamento pode intensificar a violência em favelas, já estigmatizadas como áreas de “alto risco”, enquanto bairros de classe média ou alta seriam tratados de forma mais branda.

O especialista explica que, no Rio de Janeiro, a maioria dos territórios habitados por população negra é lido como violento, logo as tecnologias refletiram essa lógica: “Não é preciso ter o dado de raça no banco de dados para inferir a raça de uma pessoa. Pode-se inferir isso por outros elementos, por exemplo, pelo CEP da pessoa”.

Dados publicados pelo CESeC em 2022 mostraram que 63% das pessoas abordadas pela polícia são negras. No mesmo ano, as pessoas negras representaram 76,5% dos homicídios no país, de acordo com o Atlas da Violência 2024.

Sorria, você está sendo vigiado!

A adoção de tecnologias de inteligência artificial pode violar outro direito garantido por lei: o da privacidade. Ainda que a Lei Geral de Proteção de Dados (LGPD) determine uma regulamentação para o uso de dados para fins de segurança pública, a norma ainda não foi estabelecida, o que expõe milhões de brasileiros ao uso indevido de seus dados, como golpes e perseguições políticas .

Episódios nesse escopo já aconteceram. Em 2024, o Córtex, uma das maiores ferramentas de vigilância do Brasil desenvolvida pelo Ministério da Justiça, sofreu um grave vazamento de dados. Os dados foram comercializados, e diversas pessoas, entre servidores públicos, artistas, empresários e até mesmo ministros do Supremo Tribunal Federal (STF) foram expostos, conforme noticiou o Intercept Brasil.

O Córtex utiliza inteligência artificial para monitorar veículos em tempo real por meio de milhares de câmeras e dados sigilosos, o que permite que agentes identifiquem a movimentação de um carro e até mesmo os acompanhantes do motorista. Os agentes também podem cruzar essas informações com dados pessoais, como emprego, salários, boletins de ocorrência e passagens pela polícia.

A falta de transparência nos algoritmos e dados utilizados, combinada com a terceirização para empresas privadas, coloca em risco direitos fundamentais como privacidade e igualdade. Essa prática pode intensificar a vigilância e a criminalização de grupos vulneráveis, como alerta a campanha “Tire meu rosto da sua mira”, que defende a proibição do uso de tecnologias digitais de reconhecimento facial na segurança pública.

A ciência já demonstrou que essas tecnologias sempre apresentam um desempenho diferenciado para traços étnicos distintos. Esse tipo de risco, mapeado cientificamente, viola princípios constitucionais como a liberdade, a igualdade e a presunção de inocência”, ressalta Horrara Moreira, advogada, conselheira de privacidade e proteção de dados no Rio de Janeiro e ex-coordenadora da campanha.

Segurança para quem e para quê?

Horrara argumenta que o policiamento preditivo poderia ser usado para investigar crimes como evasão de divisas, lavagem de dinheiro e desvio de impostos, que causam prejuízos significativos à sociedade ao desviar recursos essenciais que deveriam ser destinados à saúde, educação e moradia. A advogada salienta que, nesses casos, a análise de dados não violaria direitos constitucionais.

Ela ressalta que o policiamento preditivo “acaba servindo aos propósitos do gestor público que está formulando a política de segurança, que é construída pelo desenvolvimento sócio-histórico. Precisamos questionar: segurança para quem e para quê?”

Para a advogada, ao aplicar o policiamento preditivo em grupos específicos, é importante que os governos realizem uma “análise de risco sistêmica” para determinar quem será afetado e quais direitos podem ser potencialmente violados.

Pablo Nunes avalia que esta análise sugerida por Horrara não tem sido feita no contexto da segurança pública, já que municípios e estados têm incorporado tecnologias de reconhecimento facial sem debater o tema com a sociedade. Para o pesquisador, a rápida adoção do reconhecimento facial e de drones alimentados por algoritmos sem evidências claras da eficácia dessas ferramentas pode ocorrer também com o policiamento preditivo, de forma acrítica e com riscos ainda mais elevados.

Para enfrentar as questões relacionadas ao policiamento preditivo, Pablo sugere o monitoramento da aquisição e do uso dessas tecnologias e a propagação de conhecimento sobre os efeitos dessas práticas por meio de campanhas e dados. O especialista acrescenta ainda que garantir transparência sobre os algoritmos e dados utilizados, além de estabelecer mecanismos de controle para proteger a privacidade e evitar a discriminação devem ser os primeiros passos quando se pensa na implementação dessas tecnologias no Brasil.